Stambia

The solution to all your data integrations needs

Stambia

The solution to all your data integrations needs

La arquitectura de datos dirigida por eventos (event-driven / EDA) con Stambia

La gestión de datos es un desafío de primer orden para las organizaciones. Pero lo que es aún más crítico hoy en día es poder procesar el dato rápidamente.

Cada vez más, deseamos reaccionar en tiempo real a los eventos que ocurren en el seno de un sistema de información.

Más que la gestión del dato per se, es la gestión de los eventos que ocurren sobre los datos lo que se hace cada vez más pertinente tanto para el análisis como para la gestión operacional.

Descubra cómo capturar fácilmente sus eventos en datos con una arquitectura impulsada por eventos con ELT Stambia.

¿Por qué implementar una arquitectura EDA (event-driven) para los datos?

Tener datos más frescos para el análisis

El primer desafío es poder tomar decisiones de manera inmediata.

Ahora bien, para tomar una decisión hace falta información.

Adquirir, detectar datos, en tiempo real o de forma continua, permite construir sistemas analíticos (decisionales) que proporcionan una vista inmediata de la situación.

Los flujos de integración de datos deben entonces permitir a la vez un procesamiento de grandes volúmenes (agregaciones, ingesta de datos completos) pero también un procesamiento de pequeños volúmenes, en tiempo real.

Reaccionar rápidamente a eventos de datos

En ciertas áreas, el tiempo de reacción es crítico. Podemos pensar en las líneas de producción industrial que funcionan bajo un flujo tenso: al menor fallo o al menor retraso se pueden generar consecuencias sobre toda la cadena de valor.

Es por esto que es importante poder detectar aguas arriba el menor indicio que permita reaccionar de la manera más rápida. Esta detección será posible si sabemos integrar los datos provenientes de los sensores de los equipos industriales.

La constatación será la misma para el procesamiento de un pedido o de incidentes asociados al pedido. Mientras más rápidamente seamos prevenidos, más probable es que podamos actuar a tiempo.

Captar las informaciones y datos provenientes de la web

Hoy en día se sabe que no todos los datos se encuentran dentro de una organización. Muchos análisis de datos o procesos de gestión integran actualmente datos externos (como el clima, el comportamiento de la bolsa, las tasas de cambio, etc.).

Estos datos están en gran parte disponibles en internet, ya sea de manera pública o por medio de API privadas.

Se ha convertido en algo indispensable para toda empresa estar en la capacidad de recolectar informaciones externas para conocer el estado de su ecosistema y optimizar las operaciones.

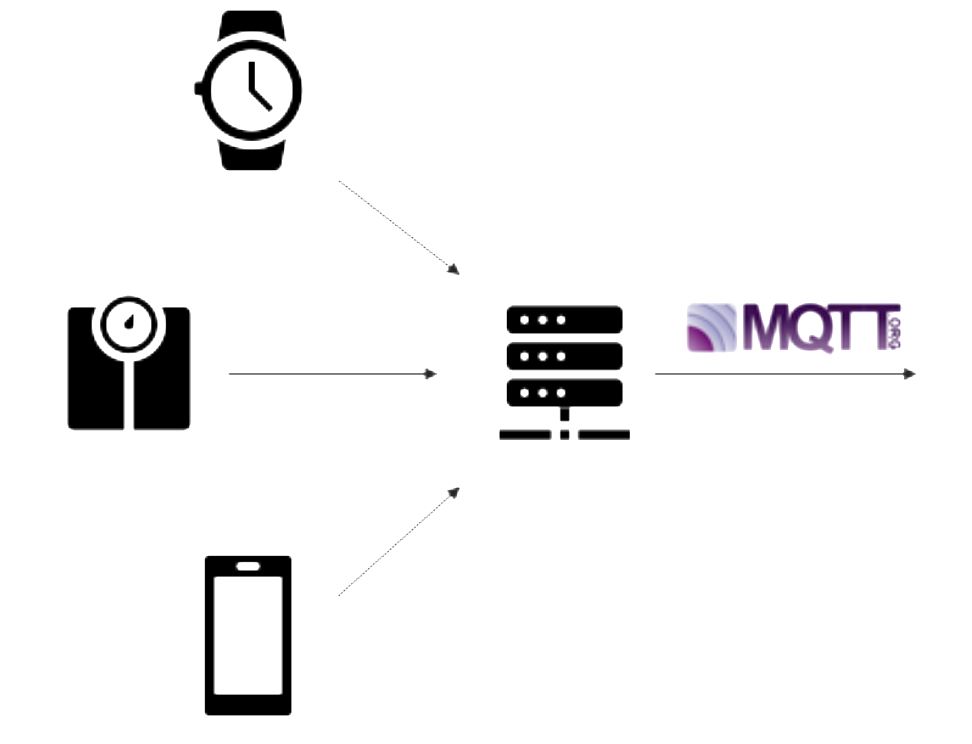

Captar informaciones provenientes de objetos conectados (IOT)

Los objetos conectados (IOT) dan mucho de qué hablar.

Efectivamente, todo individuo dispone hoy en día de al menos un objeto conectado permanentemente al alcance de la mano (teléfono, reloj, computadora, balanza, refrigerador, aspirador, ...).

Cada uno de estos objetos contiene información sobre sí mismo (su propia salud) o sobre la actividad, incluso la salud, de quien lo utiliza.

Esta información, extraída y utilizada en el momento correcto, puede aportar grandes servicios no solamente a las organizaciones sino también a los individuos, permitiendo incluso, a veces, salvarles la vida.

La implantación de mecanismos de detección de datos provenientes de objetos conectados puede entonces ser un elemento clave en el éxito de ciertos proyectos de empresa.

Cómo detectar y gestionar eventos con Stambia

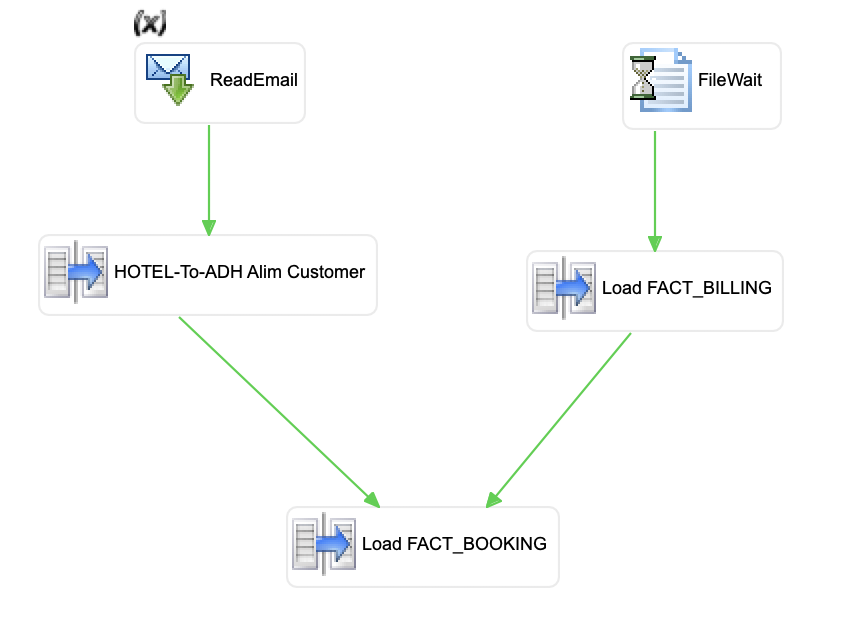

Los eventos de sistema (archivos, emails, ...)

Uno de los principales tipos de evento es la presencia de datos en los periféricos del sistema.

La presencia de archivos en una carpeta, en un servidor FTP o SSH, o incluso la presencia de un email con un archivo adjunto.

Este sigue siendo todavía el evento más utilizado en el seno de las organizaciones.

Stambia propone mecanismos de detección inteligente de estos eventos, así como mecanismos de gestión automatizados, como la creación o la alimentación automática de tablas de seguimiento y monitorización de estos eventos.

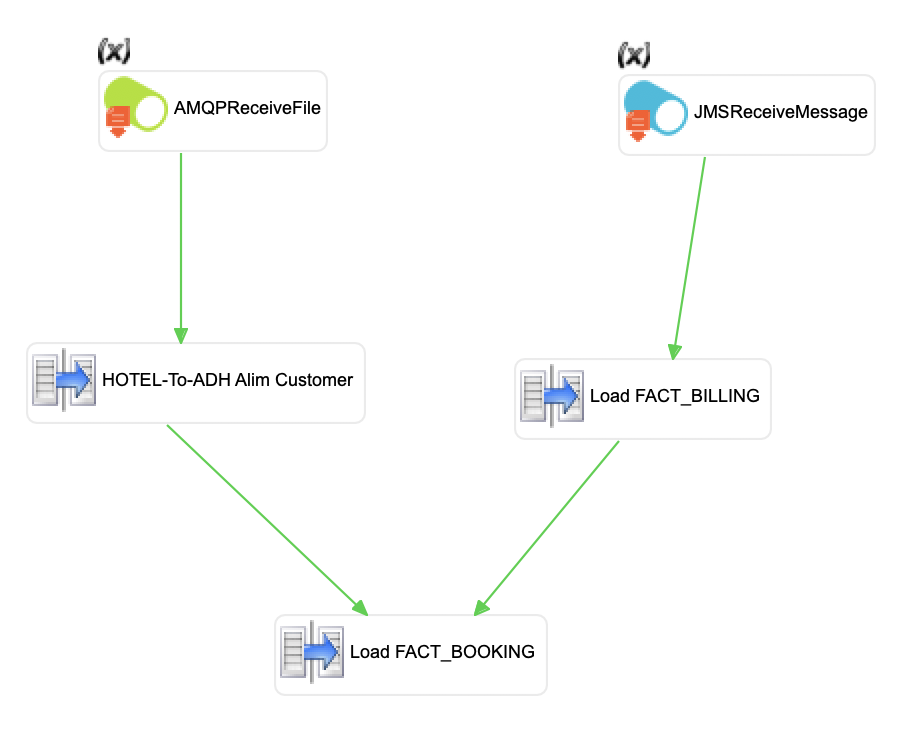

Los eventos de tipo mensaje (ESB, MOM, Kafka, JMS?, AMQP, MQTT...)

Cada vez más presentes en el seno de las organizaciones, las arquitecturas basadas en mensajes con mecanismos de "publish & subscribe" también son fuente o destino de los procesamientos de Stambia.

Del tradicional conector JMS o AMQP, al uso de buses de código abierto como Kafka, la recepción o publicación de mensajes se hace gráficamente, permitiendo el diseño de flujos de tipo asíncrono o en modo streaming.

Los datos físicos (Objetos conectados / MQTT / Sensores / ...)

Los datos provenientes de sensores o de objetos conectados también son elementos importantes en el proceso de digitalización de ciertas organizaciones.

Stambia permite conectarse a estas fuentes (o también destinos) de datos utilizando protocolos estándares propios de estas arquitecturas, tales como MQTT para los objetos conectados y OPC para los sensores industriales.

La ventaja de la solución de Stambia es mantener un único modo de despliegue para cualquier tipo de proyecto, de fuente, de destino, o de frecuencia de ejecución de los procesamientos.

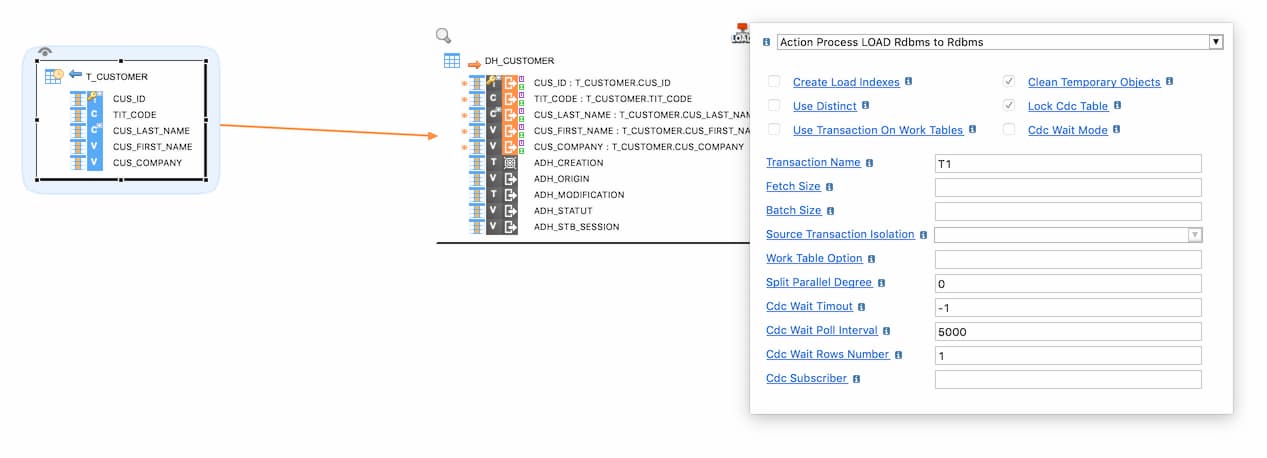

La detección de cambios (CDC, Change Data Capture)

Los datos importantes todavía provienen mayoritariamente de aplicaciones tradicionales, que reposan frecuentemente sobre bases de datos relacionales.

De manera que la detección de cambios en estas bases de datos, mediante mecanismos de Change Data Capture, sigue siendo uno de los elementos más pertinentes para alimentar sistemas en tiempo cuasi real.

Stambia propone, de forma nativa, funcionalidades de detección de cambios en las bases de datos de origen (fuente). Estas detecciones de cambios con Stambia pueden hacerse de varias maneras:

- Por medio de un disparador (trigger) en las tablas y objetos

- Por medio de las API de CDC suministradas por los desarrolladores de bases de datos.

- Por medio de la lectura de registros (log) de bases de datos (cuando estos son legibles).

- Por medio de asociaciones o alianzas con desarrolladores especializados en este tipo de detección

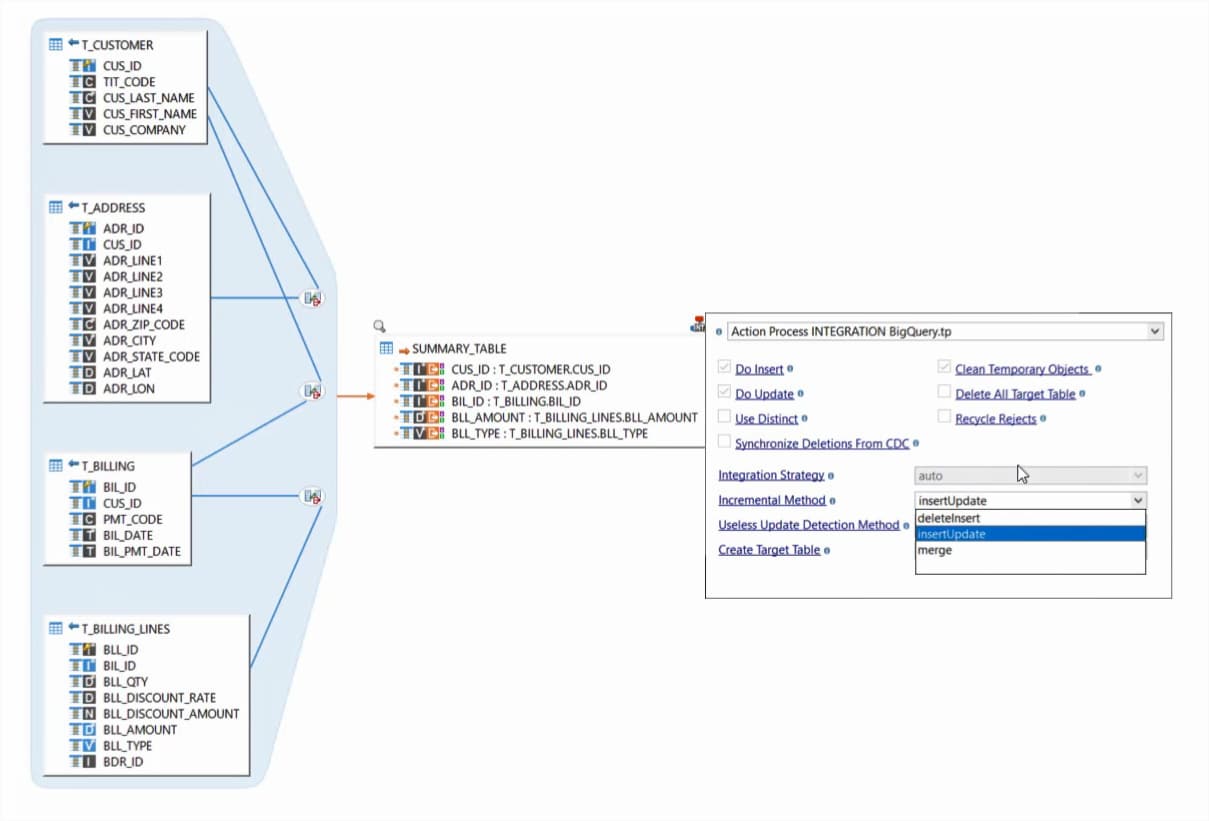

Una vez ejecutadas estas detecciones, Stambia automáticamente toma en cuenta en sus mapeos los datos que han cambiado en la fuente de origen.

No es necesaria ninguna gestión adicional. Todo datos nuevo será tomado en cuenta e integrado de manera inteligente en los destinos correspondientes.

Acoplarse a integraciones inteligentes (incremental, SCD...)

La detección de cambios o de eventos es importante.

Sin embargo, un cambio en la fuente de origen no significa necesariamente un cambio en los destinos.

Efectivamente, en función del dato modificado en la fuente, así como de lo que haya pasado mientras tanto en el destino, es posible que no sea necesario aplicar la modificación en los sistemas de destino.

Para tomar en cuenta estas reglas particulares de gestión, Stambia pone a su disposición modos de integración de destino que permitirán integrar inteligentemente los datos.

Por ejemplo, el modo "incremental" permitirá comparar los datos de las fuentes, provenientes de cambios detectados, con los datos de destino ya existentes y de decidir si es necesario insertar, actualizar o historizar los datos.

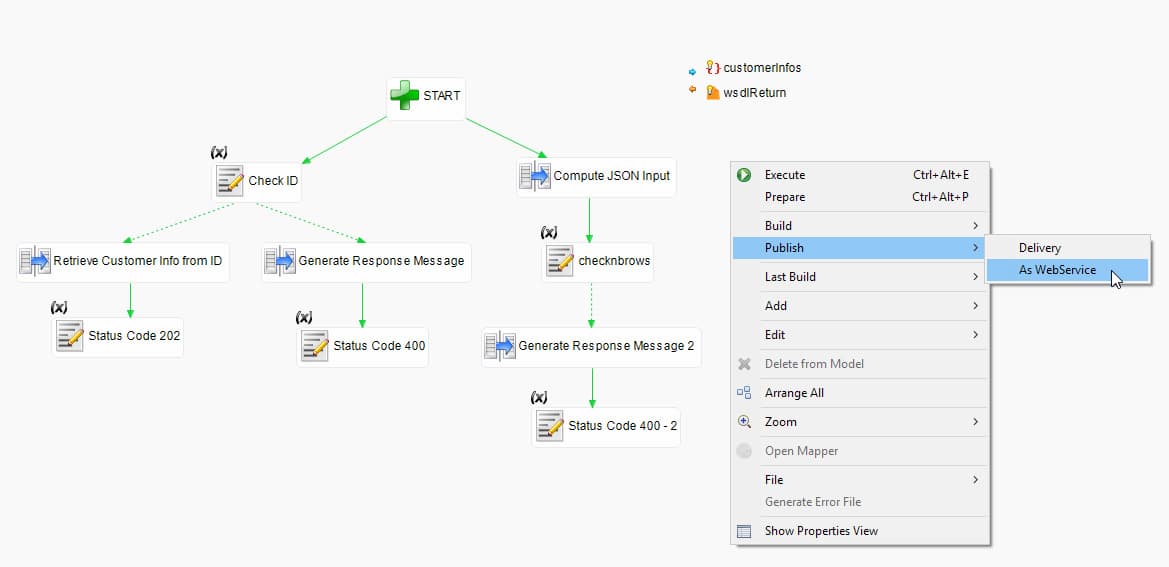

La utilización de servicios web / Arquitectura SOA

Una solución eficaz debe reaccionar inmediatamente y de manera sincronizada apenas se produce un evento.

La arquitectura SOA es igualmente un enfoque pertinente. Stambia permite exponer servicios web de manera gráfica y sin una sola línea de código.

Estos servicios web pueden ser llamados por todo tipo de programa y ser luego integrados a los procesos de gestión de la empresa.

Esto permite no solamente reaccionar inmediatamente, sino también ubicarse en un sistema de preguntas/respuestas entre las aplicaciones.

La construcción de procesos de gestión complejos puede entonces ser realizada con gran simplicidad y agilidad.

Especificaciones técnicas y prerrequisitos

| Especificaciones | Descripción |

|---|---|

|

Una arquitectura simple y ágil |

1. Designer: ambiente de desarrollo |

|

Conectividad |

•• Cualquier base de datos relacional, como por ejemplo Oracle, PostgreSQL, MSSQL, ... Para saber más, consulte nuestra documentación técnica |

|

Protocolos |

FTP, FTPS, SFTP, SSH |

| Integración de datos - Funcionalidades estándar |

|

|

Integración de datos - Funcionalidades avanzadas |

|

|

Prerrequisitos técnicos |

• Sistemas operativos: ○ Windows XP, Vista, 2008, 7, 8, 10 en modo 32 o 64 bits ○ Linux en modo 32 o 64 bits ○ Mac OS X en modo 64 bits • Memoria ○ Al menos 1 Gb de RAM • Espacio de disco ○ Como mínimo debe tener 300 Mb de espacio disponible en disco • Ambiente Java ○ JVM 1.8 o superior Notas : para Linux, es necesario disponer de un sistema de interfaz gráfica GTK+ 2.6.0 con todas las dependencias |

| Nube | Image Docker disponible para los motores de ejecución (Runtime) y la consola operativa (Production Analytics) |

| Soporte estándar |

|

| Scripting | Jython, Groovy |

| Sistemas de gestión de versiones | Cualquier plugin soportado por Eclipse : SVN, CVS, Git, … así como cualquier sistema de archivos compartidos (Google Drive, One Drive / Sharepoint, Drop Box…) |

| Migrar desde otras soluciones | Oracle Data Integrator (ODI) *, Informatica, Datastage, talend, Microsoft SSIS * posibilidad de migrar de manera rápida y simple |

¿Desea saber más?

Consulte nuestros diferentes recursos

¿No ha encontrado lo que buscaba en esta página?

Consulte el resto de nuestros recursos:

Stambia anuncia su fusión con Semarchy the Intelligent Data Hub™

Stambia Data Integration se convierte en Semarchy xDM Data Integration